log

assets

第二节讲义_1682136737988_0

journals

loom

pages

static

css

fonts

inter

icons

img

js

excalidraw-assets

locales

pdfjs

cmaps

tags

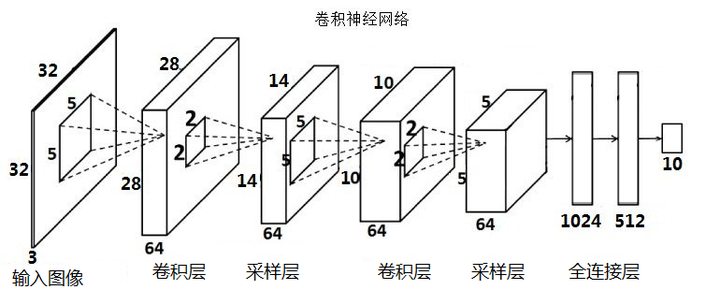

CNN学习

- 简要理解:通过第一个卷积层提取最初特征,输出特征图

- 通过第一个采样层对最初的特征图进行特征选择,去除多余特征,重构新的特征图

- 通过第二个卷积层对上一层的采样层的输出特征图进行二次特征提取

- 第二个采样层也对上层输出进行二次特征选择

- 全连接层就是根据得到的特征进行分类

- 神经网络:

- 以最少的代价,使神经网络获得最好的准确率

- 特征和特征选择

- 一事物异于其他事物的特点

- 信息熵

- 信息的不确定性

-

- 当一个事件发生的概率p(x)为1并且它发生了,那我们等到的信息量是h(x) = 0。

-

- 当一个事件发生的概率p(x) 为0 并且它发生了,那我们得到的信息可能是无限大。

-

- 我认为本质就是我要获得某些信息的代价,当信息的稀有度越高,得到这个信息需要付出的代价越高

- 信息的不确定性

- 卷积

- 系统某一时刻的输出是由多个输入共同作用(叠加)的结果。

- 图像的锐化和边缘检测很像,我们先检测边缘,然后把边缘叠加到原来的边缘上,原本图像边缘的值如同被加强了一般,亮度没有变化,但是更加锐利。

- 换句话来说,卷积可以充当对原图像二次转化,提取feature的作用

- (1)原始图像通过与卷积核的数学运算,可以提取出图像的某些指定特征(features)。

- (2)不同卷积核,提取的特征也是不一样的。

- (3)提取的特征一样,不同的卷积核,效果也不一样。

- 卷积层padding 的目的:

- 1.获得更多的图像边缘信息

- 2.是的卷积层输出的特征图和原来一样大(或者稍微小一点),让CNN的特征提取不那么早就结束

- 采样层(池化层)

- 取出最符合的特征

- 有最大池化等等

- 取出最符合的特征

- 激活函数 最重要,增强模型的分线性表达能力

- 提高模型鲁棒性,非线性表达能力,缓解梯度消失问题,将特征图映射到新的特征空间从何更有利于训练,加速模型收敛等问题都有很好的帮助

- 全连接层

- 就是它把特征representation整合到一起,输出为一个值大大减少特征位置对分类带来的影响

- 只用一层fully connected layer 有时候没法解决非线性问题而如果有两层或以上fully connected layer就可以很好地解决非线性问题了

- dropout层

- 将无用的特征删去

Table Of Contents